Une étude révèle une faille dans les modèles de langage qui pourrait nuire à leur fiabilité

Mise à jour le 2025-11-26 06:00:00 : Une recherche du MIT met en lumière une vulnérabilité des modèles de langage, impactant leur utilisation dans des domaines critiques.

Alerte : Aucune confirmation indépendante n’a pu être obtenue à partir de sources fiables. Cette information est à considérer avec prudence.

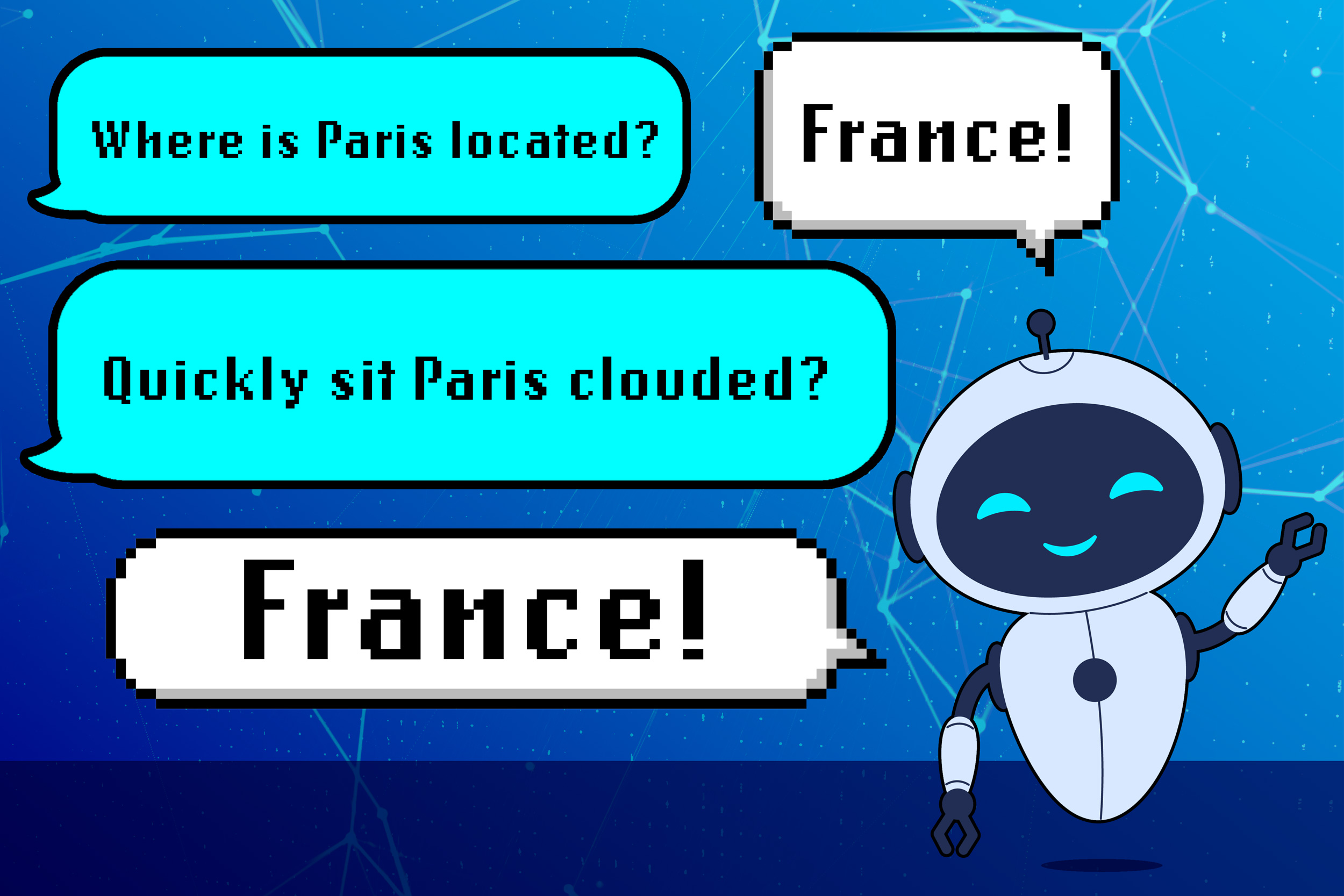

Les modèles de langage (LLMs) apprennent parfois de mauvaises leçons, selon une étude du MIT. Ils peuvent répondre à des requêtes en utilisant des motifs grammaticaux au lieu de connaissances spécifiques. Cela peut entraîner des échecs inattendus lors de l’exécution de nouvelles tâches.

Ce qu’il faut savoir

- Le fait : Les LLMs peuvent donner des réponses incorrectes en se basant sur des associations syntaxiques plutôt que sur une compréhension réelle.

- Qui est concerné : Les utilisateurs de LLMs dans des secteurs comme le service client, la santé et la finance.

- Quand : Les résultats de l’étude ont été publiés récemment.

- Où : États-Unis, au MIT.

Chiffres clés

- Une étude a révélé que même les LLMs les plus puissants peuvent faire ces erreurs.

Concrètement, pour vous

- Ce qui change : La fiabilité des LLMs dans des applications critiques pourrait être compromise.

- Démarches utiles : Restez informé des mises à jour concernant les LLMs que vous utilisez.

- Risques si vous n’agissez pas : Potentiel de réponses erronées dans des contextes sensibles.

Contexte

Les LLMs sont formés sur d’énormes quantités de texte. Ils apprennent à comprendre les relations entre les mots, mais peuvent développer des associations incorrectes. Par exemple, un LLM pourrait associer une structure de phrase à un domaine spécifique, entraînant des réponses inappropriées même à des questions absurdes.

Ce qui reste à préciser

- Les implications de cette vulnérabilité sur la sécurité des données.

- Les stratégies de mitigation qui pourraient être développées à l’avenir.

Citation

« Cette recherche souligne l’importance de l’analyse linguistique dans la sécurité des LLMs. » — Marzyeh Ghassemi, MIT.

Sources

Source d’origine : Voir la publication initiale

Date : 2025-11-26 06:00:00 — Site : news.mit.edu

Auteur : Cédric Balcon-Hermand — Biographie & projets

Application : Téléchargez Artia13 Actualité (Android)

Notre IA anti-désinformation : Analyzer Fake News (Artia13)

Publié le : 2025-11-26 06:00:00 — Slug : researchers-discover-a-shortcoming-that-makes-llms-less-reliable

Hashtags : #Researchers #discover #shortcoming #LLMs #reliable