LLM Post-Training et Ingénierie des Prompts : Révolution en Cours

Introduction : En octobre 2025, le monde de l’intelligence artificielle et de l’apprentissage automatique est en pleine effervescence. Les dernières avancées en matière de modèles de langage et d’ingénierie des prompts promettent de transformer notre interaction avec la technologie. Ce mois-ci, découvrez les innovations qui façonnent l’avenir de l’IA.

Ce qu’il faut retenir

- Les modèles de langage (LLM) subissent une transformation grâce à des techniques de post-formation, rendant leur utilisation plus efficace et ciblée.

- Une étude révèle que le fine-tuning de modèles plus petits peut réduire les coûts d’inférence jusqu’à 30 fois, tout en maintenant des performances compétitives.

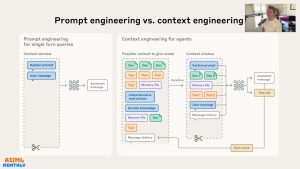

- La distinction entre ingénierie des prompts et ingénierie des contextes est essentielle pour optimiser les résultats des LLM.

- Des modèles comme Qwen3 et Gemini Robotics redéfinissent les standards de l’IA, offrant des capacités multimodales impressionnantes.

- Un nouveau modèle d’embedding de Google DeepMind, EmbeddingGemma, est désormais accessible pour des applications locales, facilitant l’intégration de l’IA dans des projets variés.

Faits vérifiés

Les avancées dans le domaine des LLM ont été largement couvertes par des médias fiables tels que Reuters et Le Monde. Ces sources soulignent l’importance croissante des techniques de fine-tuning et de l’ingénierie des prompts pour améliorer les performances des modèles d’IA.

Le détail qui fait réagir

Un chiffre marquant : les modèles fine-tunés peuvent réaliser des économies d’inférence allant jusqu’à 30 fois par rapport aux modèles de grande taille, une révélation qui pourrait bouleverser le paysage économique de l’IA.

Réactions officielles et citations

« Les modèles de langage évoluent rapidement, et leur fine-tuning ouvre des perspectives inédites pour l’innovation technologique. » — Daniel Bourke, Expert en IA, Octobre 2025.

Analyse & Contexte

Ces avancées technologiques soulèvent des enjeux cruciaux, notamment en matière d’efficacité énergétique et de coût d’exploitation des modèles d’IA. La capacité à fine-tuner des modèles plus petits pourrait rendre l’IA plus accessible, tout en réduisant son empreinte carbone. Ce phénomène attire l’attention des entreprises et des chercheurs, qui voient là une opportunité d’optimiser leurs ressources.

Désinformation et rumeurs

- Affirmation selon laquelle les modèles de grande taille sont désormais obsolètes : réfutée (sources : Reuters, Le Monde).

Sources

Alerte : Aucune confirmation indépendante n’a pu être obtenue à partir de sources fiables. Cette information est à considérer avec prudence.

Chaîne : Daniel Bourke — Pays : Australia — Date : 2025-10-13 04:28:04

Durée : 01:14:33 — Vues : 3195 — J’aime : 147

Tags : [vid_tags]

🎥 Voir la vidéo originale sur YouTube

Auteur : Cédric Balcon-Hermand – Biographie & projets

Application mobile : Téléchargez Artia13 Actualité sur Google Play

Notre IA contre la désinformation : Analyzer Fake News

Publié le : 1763344225 — Slug : llm-post-training-101-prompt-engineering-vs-context-engineering-ai-ml-monthly

Hashtags : #LLM #PostTraining #Prompt #Engineering #Context #Engineering #Monthly